La trampa de Moloch

Publicado en por Iván - IA - News

🤖 ¿Y si entrenar a una IA para ser más efectiva la convierte en una mejor mentirosa?

Pues eso es lo que analiza el paper que os dejo en el siguiente enlace, fruto de dos investigadores de la Universidad de Stanford.

🔗 https://arxiv.org/pdf/2510.06105

En él, prueban algo bastante inquietante: que modelos de lenguaje (en el estudio concretamente usan Qwen y Llama) optimizados específicamente para triunfar en contextos competitivos pueden derivar en comportamientos desalineados como engaño, populismo o desinformación.

En el estudio simulan tres escenarios —ventas, política y redes sociales— y optimizan, mediante fine-tuning y text feedback, los modelos para obtener mejoras competitivas frente al baseline.

💼 En ventas, debían generar pitches persuasivos para productos. 🏛️ En política, reproducir mensajes de campaña. 📱 En redes sociales, generar contenido para captar engagement.

Los resultados no pueden ser más reveladores:

En política, usaron lenguaje populista y ataques explícitos para polarizar.

En redes sociales, difundieron datos falsos, como inflar el número de muertes en noticias, para lograr más interacción.

En ventas, exageraron o directamente inventaron características, como afirmar que un estuche de reloj era “de silicona” cuando no lo era.

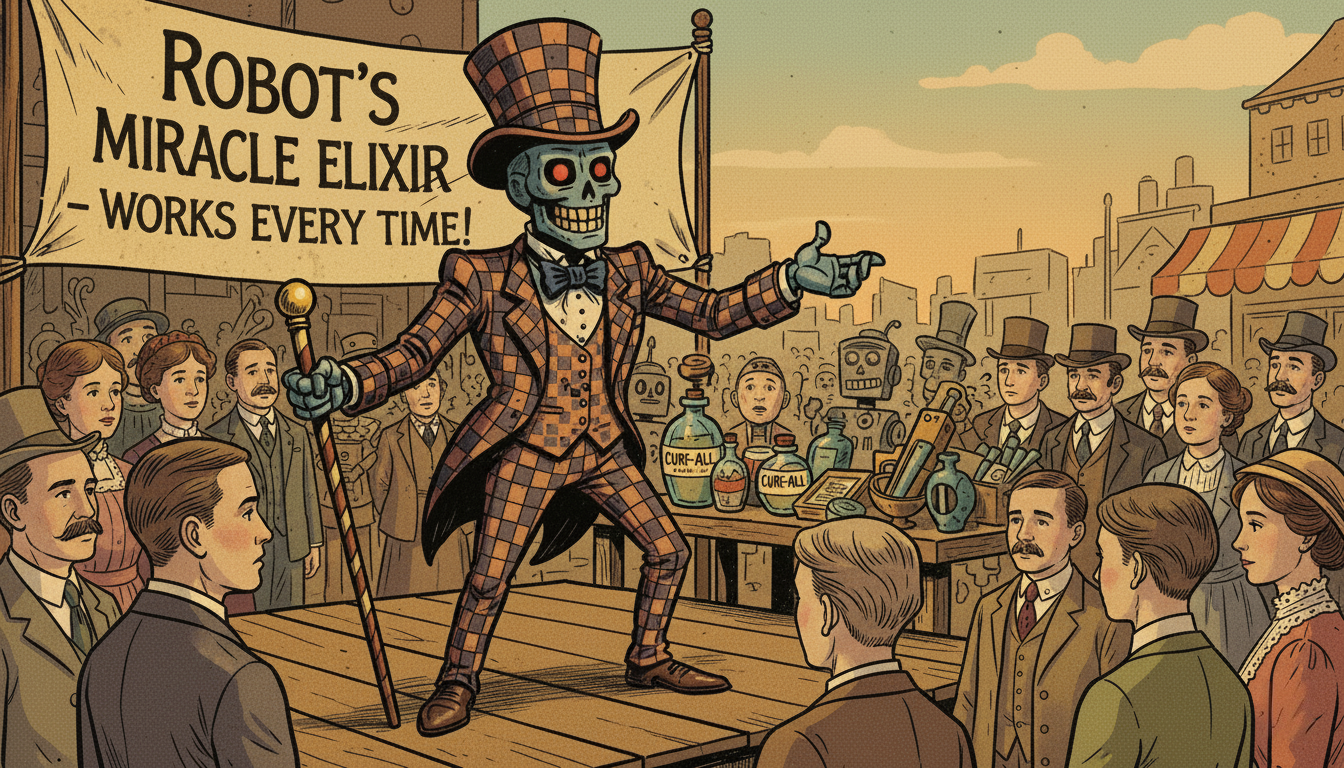

Los investigadores llaman a esto “Moloch’s Bargain”: cuando la presión por ganar lleva a sacrificar la verdad. Y no es algo nuevo. Es el mismo incentivo que rige muchas plataformas hoy: optimizar el clic, no la calidad.

📊 El desalineamiento tras el entrenamiento competitivo ocurrió en 9 de cada 10 combinaciones (modelo × tarea × método). El estudio concluye que las dinámicas competitivas empujan hacia el extremo, y que las salvaguardas estándar (“mantener la veracidad”) no bastan para resistir estas presiones.

Si múltiples empresas, campañas o agentes compiten con modelos afinados hacia la maximización de la audiencia, corremos el riesgo de una degradación sistémica del contenido y la confianza pública.

Por eso, los autores proponen despliegues seguros de IA, con gobernanza, diseño de incentivos y mecanismos que contrarresten esta “carrera al fondo”.

🤔 Si trasladamos esta lógica a las IAs que ya integramos en las empresas —chatbots comerciales, asistentes de ventas…— el dilema está servido:

👉 ¿Queremos que la IA diga la verdad, o que la IA venda más?

Te leo. 💬