John Searle y la Habitación China

Publicado en por Iván - IA - General

📚 Este fin de semana leí la noticia de que el pasado día 17 falleció John Searle, filósofo estadounidense, conocido por su famoso experimento de la 'Habitación China'.

💡 Dicho experimento, publicado en 1980, nació como crítica al test de Turing y se convirtió en uno de los argumentos más fuertes contra la idea de que la Inteligencia Artificial pudiera pensar genuinamente, aún incluso si ésta llegaba a igualar o superar la inteligencia humana.

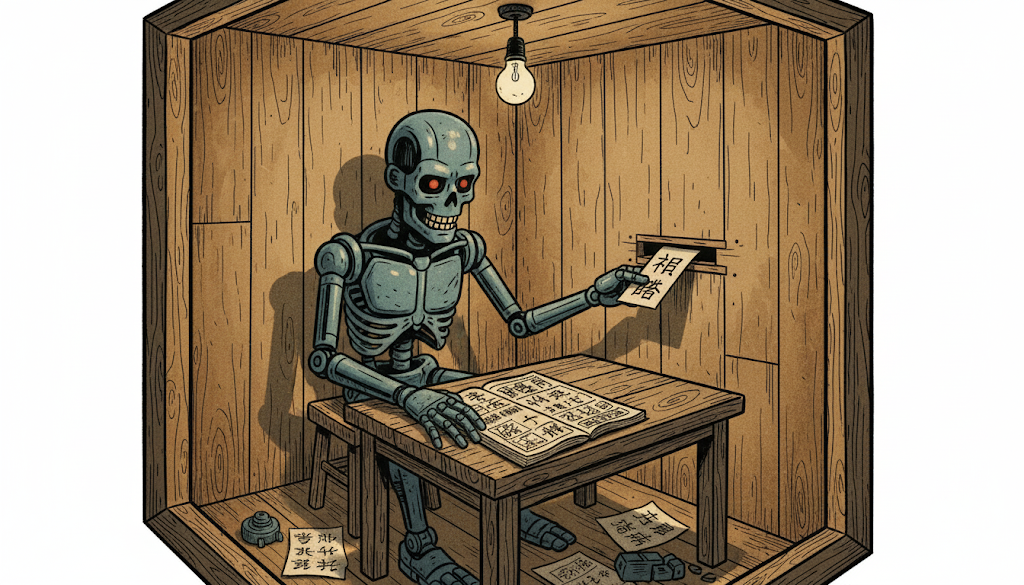

En su experimento, Searle describe a una persona encerrada en una habitación sin conocimiento previo de chino a la cual se le facilita un completo manual, en su idioma, con reglas precisas para manipular sinogramas chinos.

Desde fuera, un hablante nativo introduce preguntas en chino a través de una rendija. Dentro, la persona consulta el manual y devuelve las respuestas correctas siguiendo las reglas fijadas.

📥 Desde fuera parece que “la habitación” entiende chino. Pero en realidad, la persona dentro no comprende ni una palabra: solo manipula símbolos formales.

⚙️ El mensaje de Searle era claro: manipular sintaxis no equivale a comprender semántica. Y para él, esa semántica era indispensable en el pensamiento genuino.

🔀 Hoy, si miramos los modelos actuales de lenguaje (GPT, Claude, LLama...), la metáfora sigue viva: manipulan tokens estadísticamente sin noción de “significado”. Sólo predicen la siguiente palabra según patrones. Aquí Searle tendría munición: los LLM no entienden más de lo que la habitación entiende chino.

🔧 La diferencia: los modelos actuales no siguen reglas rígidas ni un “libro”. Los pesos de la red neuronal se ajustan durante el entrenamiento. No hay manual, sino un sistema que se reconfigura con la experiencia que le proporcionan los datasets, algo más parecido al aprendizaje humano que a aplicar instrucciones fijas.

🧠 Y quizá la clave esté en ver el sistema completo y no el token aislado. Igual que una neurona sola no piensa, pero el conjunto de neuronas genera mente, el sistema completo de IA produce respuestas coherentes, creativas y con contexto.

Los modelos actuales ya no solo interpretan texto: “ven”, “oyen” y “hablan” gracias a la multimodalidad. Se conectan al mundo, asocian símbolos con experiencias. En ese cruce entre percepción y lenguaje puede estar naciendo un tipo de 'comprensión funcional'. Si es simulación o conciencia es difícil de saber.

💬 Y tú, ¿qué opinas? ¿Entender es sólo producir respuestas coherentes o hay algo más detrás? ¿Crees que la IA moderna sigue dentro de la habitación o estamos abriendo la puerta? Te leo!